Zarządzanie podatnościami. Nowe podejście do starego problemu IT

W coraz bardziej scyfryzowanym świecie, w którym praca zdalna to nie przywilej, lecz konieczność, a większość ludzi ma co najmniej jedno urządzenie podłączone do internetu bądź sieci lokalnej, problem zapewnienia bezpieczeństwa cyfrowego staje się nieodłącznym elementem naszego życia. Dlatego postanowiłem opisać najlepsze praktyki branży finansowej, w tym z State Street.

Patryk Solecki. Globalny menadżer ds. zapobiegania zagrożeniom w State Street, z firmą związany od 2020 roku. Kieruje zespołem inżynierów cyberbezpieczeństwa i programistów tworzących rozwiązania bezpieczeństwa dla infrastruktury IT, aplikacji i chmury. Swoją karierę rozpoczynał jako inżynier sieciowy oraz tester oprogramowania i systemów. Ma doświadczenie menadżerskie w dostarczaniu usług cyberbezpieczeństwa dla ponad 150 klientów z całego świata i tworzenia wydajnych zespołów IT. Posiada m.in. certyfikaty Qualys Certified Specialist: Vulnerability Management, CompTIA Security+, ITIL Foundation in IT Service Management.

Cyberbezpieczeństwo wyewoluowało przez ostatnie lata z dziedziny niszowej, nieprzyciągającej uwagi większości pracowników oraz zarządu, do kluczowego obszaru rozwoju. Stało się także częścią cyfrowej transformacji wielu firm, jak i administracji wielu krajów. Ten sam wzrost zainteresowania obserwuje się w jednej z gałęzi cyberbezpieczeństwa – w tzw. zarządzaniu podatnościami (ang. vulnerability management).

Co zmieniło się w tym obszarze, a także w samych podatnościach na przestrzeni ostatnich lat? Jak to wpływa na globalny rynek IT i cyberbezpieczeństwa oraz jakie rozwiązania do zarządzania podatnościami i monitorowania zagrożeń oferują firmy? O tym dowiecie się już za chwilę.

Spis treści

Na początku była… podatność

Podatności towarzyszą nam od kiedy tylko nauczyliśmy się wytwarzać oprogramowanie. W przeszłości wiedza o podatnościach oraz metody ich odkrywania, klasyfikowania i katalogowania były bardzo ograniczone z wielu powodów, m.in. stosunkowo niskiej świadomości w dopiero raczkującej branży IT, braku specjalistycznych narzędzi czy też zorientowania procesu wytwarzania oprogramowania na dostarczenie funkcjonalności.

Z biegiem czasu coraz większą wagę przywiązywano do jakości tworzonych produktów (ang. quality assurance) i uwaga wszystkich zaczęła rozdzielać się między funkcjonalność a jakość. I to właśnie z jakości wyodrębniony został specyficzny typ defektów i bugów – te z nich, które dotyczyły bezpieczeństwa aplikacji zaczęto klasyfikować odrębnie, jako podatności (ang. vulnerabilities) bądź defekty bezpieczeństwa (ang. security defects).

Jednym z przełomowych momentów w historii śledzenia i dostępu do informacji o podatnościach było utworzenie bazy danych CVE przez organizację MITRE w 1999 roku. Równolegle do bazy MITRE, podobną inicjatywę podjął amerykański instytut NIST, uruchamiając bazę ICAT (prekursor dzisiejszej bazy NVD). Celem obu baz było katalogowanie informacji o podatnościach na podstawie uniwersalnych identyfikatorów podatności – CVE (ang. Common Vulnerabilities and Exposures). Kolejnym ważnym momentem było wprowadzanie protokołu SCAP a następnie zaadoptowanie tego protokołu przez bazę NIST NVD w 2007 roku.

Protokół SCAP (Security Content Automation Protocol) zapewnia szeroko pojętą standaryzację klasyfikowania podatności, używając do tego standardów takich jak: CVE, CCE, CPE, CVSS, XCCDF czy OVAL, dzięki którym każda upubliczniona podatność zyskiwała nie tylko unikalny identyfikator i opis (CVE), ale też korelację z produktem, na którym została znaleziona (CPE) oraz znormalizowaną ocenę ryzyka, jakie niesie ze sobą podatność (CVSS). Na dostępie do tych informacji opiera się do dzisiaj każdy komercyjny skaner podatności i wiele firm wciąż używa standardów protokołu SCAP w swoim programie zarządzania podatnościami – pytanie tylko, czy to podejście nadal jest aktualne i skalowalne w 2021 roku?

Prawo popytu, prawo podaży

Ostatnie 10 lat przyniosło lawinowy napływ nowych informacji i szereg gwałtownych zmian w świecie IT. Ten trend nie ominął też zarządzania podatnościami. O ile próba standaryzacji i upublicznienia, a także ułatwienia dostępu do informacji o podatnościach i zagrożeniach była krokiem milowym w pierwszej dekadzie XXI wieku, o tyle druga dekada ujawniła niedoskonałości istniejącego systemu. Użytkownicy instalujący coraz więcej typów oprogramowania, nowe języki programowania, wirtualizacja a później konteneryzacja, czy wreszcie globalna migracja aplikacji z fizycznych i wirtualnych serwerów do chmury spowodowały, że liczba podatności do odkrycia wzrosła do niewyobrażalnego wcześniej poziomu.

Odizolowane wcześniej środowiska przeniosły się do internetu, zwiększyła się liczba “inteligentnych” urządzeń elektronicznych przypadających na jednego użytkownika, a czynności które jeszcze kilka lat temu wykonywaliśmy w świecie realnym, przeniosły się do rzeczywistości wirtualnej; sztandarowym przykładem są usługi administracyjne, telemedycyna czy bankowość internetowa. Postęp techniczny wywołał jednocześnie zwiększone zainteresowanie światem cyberprzestępczości i doprowadził do powstawania samodzielnych biznesów czerpiących zyski z oszukiwania ludzi bądź kradzieży w przestrzeni cyfrowej. Wraz z rozwojem „ciemnej strony mocy” pojawili się również badacze bezpieczeństwa, wykorzystujący swoją wiedzę do tego, by we współpracy z firmami znajdować luki bezpieczeństwa w ich produktach.

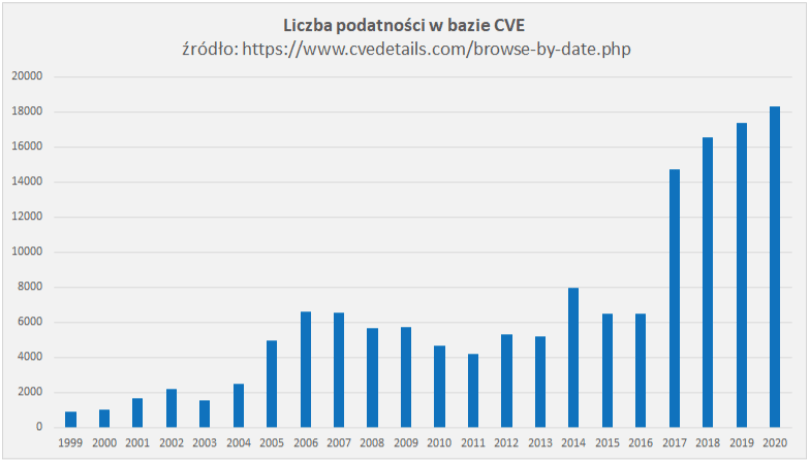

Co to znaczy dla osób zarządzających heterogeniczną i dosyć złożoną infrastrukturą IT firm? Otóż powinni znacznie zwiększyć tempo, w jakim nie tylko przyswajają informacje na temat zagrożeń, błędów konfiguracji czy dostępnych aktualizacji bezpieczeństwa, ale przede wszystkim reagują na incydenty i zapobiegają zagrożeniom. O ile u progu poprzedniej dekady wielu administratorów mogło ograniczyć się do kwartalnych lub w najlepszym przypadku comiesięcznych skanów narzędziami takimi jak Qualys VM czy Tenable Nessus i zaaplikowania najnowszych poprawek bezpieczeństwa dla systemów operacyjnych z tą samą lub mniejszą częstością, o tyle dzisiaj to podejście przestało zdawać egzamin – wykres upublicznionych podatności na przestrzeni lat odpowie na pytanie “dlaczego”:

Rok 2017 przyniósł ogromny wzrost upublicznionych (o tych nieupublicznionych z oczywistych względów nie mamy bezpośrednich danych) podatności. Zbiegło się to w czasie z kampaniami ransomware’u WannaCry czy NotPetya, które spowodowały ogromne szkody materialne w firmach i instytucjach, jakie padły ich ofiarami (m.in. Maersk, NHS UK, Deutsche Bahn, FedEx, Narodowy Bank Ukrainy). Jak widać, popyt na rozwój w IT wiąże się też ze zwiększoną podażą na wykorzystywanie tempa rozwoju do złych celów. Pozytywnych i negatywnych czynników przyczyniających się do obecnego stanu sytuacji jest wiele, ale niezmiennie prowadzą one tylko do pogłębienia problemu.

Wszystko jest krytyczne

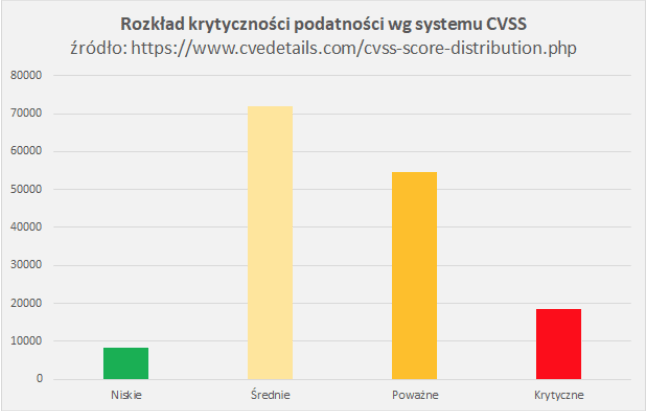

Poprzednia dekada ujawniła również niezwykle ważną słabość systemu oceny podatności CVSS. Kolejne wersje systemu konsorcjum FIRST, czyli CVSSv2 i CVSSv3, na stałe zagościły w słownikach specjalistów i kadry zarządzającej IT i są po dziś dzień szeroko wykorzystywane do priorytetyzacji remediacji podatności. Na pierwszy rzut oka CVSSv2, a później CVSSv3/3.1, wprowadziły istotne zmiany w tym, jak klasyfikujemy podatności (krytyczne, poważne, średnie i niskie) i oceniamy ich wpływ na nasze środowisko IT w skali od 0 do 10, a także zostały udoskonalone o dodatkowe metryki pozwalające np. uwzględnić poziom ryzyka (jeśli oficjalny patch istnieje lub nie).

Jednakże sposób wyliczania oceny ryzyka przez te systemy, szczególnie po 2017 roku, stał się mocno dyskusyjny, a skuteczność CVSS stawała się coraz bardziej kwestionowana przez analityków bezpieczeństwa. Zbyt dużo luk bezpieczeństwa było i jest klasyfikowanych jako krytyczne bądź poważne, przez co skanery podatności zwracają tysiące lub dziesiątki tysięcy znalezisk, które według CVSS powinny zostać zlikwidowane w pierwszej kolejności. Kolejnym problemem stało się utrwalenie CVSS jako jedynego słusznego systemu oceny ryzyka, przez co zarządy i kadra zarządzająca IT z chęcią oparły swoje wymagania co do czasu remediacji na tym, jak sklasyfikowana jest dana podatność.

“Twoja podatność ma bazowy CVSSv3 = 8.1? Proszę bardzo, musisz ją załatać w 30 dni. Nie, nie obchodzi mnie czy ta podatność dotyczy przeglądarki na maszynie bez dostępu do internetu, do której wgląd ma tylko kilka osób w firmie” – ten fikcyjny dialog, będący skrótem myślowym, pozwala zobrazować, jak to się ma w praktyce.

To, co na początku pomogło ustandaryzować tę dziedzinę bezpieczeństwa, dzisiaj coraz bardziej utrudnia skalowanie i automatyzację procesu zarządzania podatnościami. Ponadto sprawę komplikuje uwzględnienie kontekstu (kontekst w procesie priorytetyzacji remediacji podatności bardzo często bywa najważniejszy), bo jeśli wszystko jest priorytetem to znaczy, że nic nie jest priorytetem.

Co teraz?

W odpowiedzi na czynniki wymienione wcześniej, firmy działające w zarządzaniu podatnościami przeszły gruntowne zmiany, podobnie jak sama metodologia pracy. Dzisiejsze środowiska IT znacznie odbiegają od tego, co widzieliśmy jeszcze 10 lat temu, w związku z czym firmom i organizacjom coraz trudniej załatać wszystkie luki na czas lub odpowiedzieć na wszystkie alerty bezpieczeństwa jednocześnie. W efekcie przyczyniło się to do zmiany podejścia: zgodność z politykami i kontrolkami bezpieczeństwa (ang. Compliance) ustąpiła miejsca metodologii opartej o ryzyko (ang. Risk-based), która u podstaw ma już wcześniej wspomniany “kontekst” i szacowanie ryzyka na podstawie znajomości kontekstu firmy, jednostki biznesowej czy sieci LAN, w której znajduje się dany serwer.

Metoda oparta o zarządzanie ryzykiem została szeroko zaadaptowana w zarządzaniu podatnościami, a tak naprawdę zarządzanie podatnościami to szczególny przypadek zarządzania ryzykiem i większość firm obecnie skupia się na tym, aby ryzyko związane z otwartymi podatnościami w ich infrastrukturze IT było zmniejszone jak najmniejszym kosztem i w jak najkrótszym czasie. W procesie tym niezbędne jest określenie, które zasoby są dla firmy najważniejsze – to właśnie podatności na tych zasobach będą miały najwyższą wagę i najkrótszy oczekiwany czas remediacji, a jednocześnie będą powodowały największe straty wizerunkowe lub finansowe w sytuacji ewentualnego cyberataku zakończonego powodzeniem. Właśnie na takie usprawnienie zdecydowaliśmy się w State Street.

Kolejną zmianą, do której przyczynili się liderzy rynku zarządzania podatnościami, tacy jak Qualys czy Tenable, było polepszenie widoczności i skrócenie czasu identyfikacji podatności. Pierwotnie, produkty tych firm oraz ich konkurencji opierały się na skanach sieciowych wykorzystujących różne narzędzia m.in. nmap czy protokół SNMP, co prowadziło zarówno do obciążenia sieci, jak i opóźnień pomiędzy uruchomieniem i zakończeniem skanu. Dzisiaj, nowoczesne platformy do zarządzania oferują możliwość instalacji agentów uruchamianych z podwyższonym poziomem uprawnień, łączących się z chmurą na urządzeniach końcowych tak, aby zminimalizować obciążenie sieci oraz zapewnić niemal natychmiastową dostępność aktualnych informacji o stanie bezpieczeństwa danego urządzenia czy hosta bez konieczności skanowania.

Warto podkreślić, że w zależności od sytuacji, skany mogą być nadal wykorzystywane do wykrycia specyficznego rodzaju podatności lub testu (np. testu na DDOS czy sprawdzenia podatności, której wektorem ataku jest sieć lokalna).

Kontynuując podjęty wcześniej wątek kontekstu i niedoskonałości systemu CVSS, również i tutaj czołowe firmy z branży wyszły użytkownikom naprzeciw poprzez wprowadzenie integracji skanerów podatności z usługami typu Threat Intelligence. Dzięki temu umożliwiły monitorowanie aktualnych zagrożeń w oparciu o informacje z różnych publicznych i niepublicznych źródeł w czasie rzeczywistym. Informacje z baz takich jak NIST NVD i oceny CVSS zostały w ten sposób wzbogacone o bardzo ważny kontekst, mówiący czy dana podatność faktycznie jest aktualnie wykorzystywana np. przez grupy APT czy może zorganizowaną cyberprzestępczość.

Trzeba pamiętać, że nie każda krytyczna podatność to podatność, którą da się łatwo wykorzystać – być może zostanie na zawsze krytyczną podatnością tylko “na papierze” – a posiadanie takiej wiedzy jest kluczowe, jeśli “wszystko jest krytyczne” i ułatwia problem priorytetyzacji remediacji. To podatności, które są wykorzystywane w aktywnie przeprowadzonych atakach i kampaniach, są dla firm najgroźniejsze. Siłą samych rozwiązań Threat Intelligence jest też nastawienie na grupowanie zagrożeń ze względu na sektory biznesowe gospodarki, co dodaje kolejny wymiar do priorytetyzacji remediacji, bo branża finansowa będzie w kręgu zainteresowań nieco innych grup ludzi z przestępczego półświatka niż infrastruktura krytyczna, jak elektrownie czy zapory wodne podłączone do internetu.

Pójściem jeszcze o krok dalej jest automatyczna priorytetyzacja remediacji w oparciu o wszystko, co zostało wymienione w tej sekcji artykułu wspomagana przez uczenie maszynowe lub algorytmy sztucznej inteligencji i to jeden z kroków, które podjęło również State Street. Platformy, takie jak Qualys VMDR i Kenna.VM potrafią tworzyć listy podatności, które powinny zostać zamknięte w pierwszej kolejności i zredukują ogólne ryzyko dla grupy zasobów, bądź całej infrastruktury w stopniu optymalnym, biorąc pod uwagę aktualnie dostępne dane z usług Threat Intelligence, a nawet zagregowane dane o podatnościach i wykrytym złośliwym oprogramowaniu w infrastrukturach innych klientów, wykorzystujących dane rozwiązanie.

Automatyczna priorytetyzacja ogranicza też w znaczący sposób długą listę krytycznych luk, często zupełnie odbiegając od tego, co pokazałaby analogiczna analiza wyłącznie z wykorzystaniem systemu oceny podatności CVSS. Dodatkową funkcjonalnością w tego typu rozwiązaniach jest również predykcja czy dana podatność zostanie wykorzystana w najbliższym czasie i z jakim prawdopodobieństwem, co daje jeszcze jedną broń w nierównej walce z tysiącami podatności dziennie.

Ciąg dalszy nastąpi

Moc chmury, uczenia maszynowego i techniki data-mining’u umożliwiły rewolucję w dziedzinie zarządzania podatnościami i dały jeszcze raz wszystkim dużym infrastrukturom IT szansę na nadążenie za galopującym światem podatności i zagrożeń, spychając ręczną analizę w oparciu o niedoskonałe metody sprzed ponad dekady – doskonale wizualizuje to transformacja, jaką obecnie przechodzi State Street, gdzie całe podejście “starej szkoły” zostało dzięki nowym metodykom i narzędziom wywrócone do góry nogami, a sam proces zdefiniowany na nowo.

Obserwowanie tej rewolucji jest fascynujące i czas pokaże, jak skuteczne nowowprowadzone środki okażą się w stosunku do nowych zasad gry. Co niezwykle ważne, proces zarządzania podatnościami nie kończy się na wątkach poruszonych dzisiaj – bardzo często wąskim gardłem w zabezpieczaniu infrastruktury IT jest ograniczona współpraca między zespołami ds. utrzymania infrastruktury a zespołami bezpieczeństwa, bądź też niski stopień automatyzacji patchowania infrastruktury IT (lub jej całkowity brak).

Tak więc nawet najlepsze narzędzia do wykrywania, analizy i priorytetyzacji zagrożeń nie rozwiążą problemu istnienia podatności samych w sobie. No chyba, że zostaną zintegrowane w jednej platformie, ale to już temat na inny artykuł.

Zdjęcie główne artykułu pochodzi z unsplash.com. | 3612861.1.1.EMEA.RTL

Zdjęcie główne artykułu pochodzi z unsplash.com. | 3612861.1.1.EMEA.RTL

Podobne artykuły

Czym jest chmura publiczna i jak z niej korzystać w 2025 roku?

Lepiej zatrudnić specjalistę od cybersecurity, niż walczyć z ewentualną utratą danych. Wywiad z Anną Goławską

Duży menedżer haseł padł ofiarą ataku. Znowu

Oto najpopularniejsze hasło 2022 roku. Zgadniesz jakie?

Zarządzanie cyberbezpieczeństwem w globalnej infrastrukturze IT firmy farmaceutycznej

AirTag stalking - czym jest i jak się przed nim uchronić?

Cloudflare wykrywa jeden z największych ataków DDoS wymierzonych w platformę kryptowalutową