Między nami Data’owcami: transformacja danych i migracja z Cloudery do Data Lakehouse w praktyce

Współczesny świat biznesu opiera się na danych. Firmy, które potrafią je efektywnie gromadzić, analizować i wykorzystywać, zyskują przewagę konkurencyjną. Transformacja danych i migracja z Cloudery do Data Lakehouse za pomocą platformy ilum.cloud to przykład tego, jak nowoczesne rozwiązania mogą nie tylko usprawnić procesy, ale również wygenerować oszczędności i stać się katalizatorem innowacji.

Spis treści

Porozmawiajmy o obszarze Big Data. Jak ta gałąź IT zmieniła się w ostatnim czasie?

W ostatnich kilku latach digitalizacja mocno namieszała w tym, jak podchodzimy do danych. Obserwując rozwój technologii Big Data, można zauważyć, jak bardzo zmieniły się narzędzia i metody ich wykorzystywania. Codziennie pojawiają się nowe rozwiązania, które pozwalają nam lepiej zarządzać danymi, analizować je i wyciągać z nich wartość.

Jedną z kluczowych zmian, która mnie osobiście bardzo ekscytuje, jest ewolucja od tradycyjnych Data Lakes do nowocześniejszych Lakehouse’ów. To podejście integruje w sobie najlepsze cechy obu światów, elastyczność Data Lakes i zarządzanie schematami z hurtowni danych. Dzięki temu możemy efektywniej pracować z danymi, co jest niesamowicie ważne w erze AI i machine learning, gdzie szybkość i precyzja mają ogromne znaczenie.

To fascynujące, jak szybko zmienia się nasza branża. Każdego dnia czuję, że mamy do czynienia z czymś, co może zrewolucjonizować sposób, w jaki pracujemy. Dlatego tak ważne jest, abyśmy ciągle się uczyli i adaptowali do nowych rozwiązań, które pojawiają się na naszych oczach.

Czym są rozwiązania Data Lake, a czym Lakehouse’y?

Data Lake to trochę jak ogromna biblioteka, gdzie każda książka, gazeta czy notatka zostaje zachowana w jej oryginalnej formie. Możemy tu zgromadzić wszystko, od filmów po zbiory danych z sensorów, nie martwiąc się o ich format czy pochodzenie. To niesamowita zaleta, bo daje nam ogromną swobodę w przechowywaniu danych na masową skalę bez potrzeby wcześniejszej ich strukturyzacji.

Lakehouse to koncepcja, która bierze to, co najlepsze z Data Lake, czyli tę elastyczność, i łączy ją z porządkiem, jaki oferują tradycyjne hurtownie danych. W praktyce wygląda to tak, że mamy możliwość przechowywania surowych zbiorów, ale też narzędzia do ich organizacji w struktury takie jak tabele czy schematy. To ułatwia nam nie tylko przechowywanie, ale przede wszystkim efektywną analizę tych danych. Dzięki temu, gdy przychodzi co do czego, możemy szybko przekształcić surowe dane w wartościowe informacje, które pomogą podejmować lepsze decyzje biznesowe.

Myślę o Lakehouse jako o ewolucji Data Lake. To jak przechodzenie od zwykłej biblioteki do cyfrowej, gdzie wszystko jest lepiej zorganizowane i łatwiejsze do znalezienia. Przykładem może być migracja z Cloudery do innego lakehouse’u, która zazwyczaj obejmuje etapy takie jak eksport danych z HDFS, transformacja danych przy użyciu Apache Spark oraz import danych do docelowego systemu, przy zachowaniu integralności i bezpieczeństwa danych.

Brzmi to obiecująco. A jak wygląda proces migracji z Cloudery do Data Lakehouse w praktyce?

Migracja danych to zawsze duże wyzwanie, ale też szansa na ulepszenie sposobu, w jaki pracujemy z danymi. W praktyce każdy przypadek migracji może się różnić, ale istnieje kilka kluczowych kroków, które zawsze staramy się przestrzegać.

Pierwszym krokiem jest planowanie i analiza. To trochę jak przygotowanie do długiej podróży, trzeba dokładnie sprawdzić, co mamy, dokąd zmierzamy i co będzie nam potrzebne do celu. Analizujemy naszą obecną infrastrukturę danych, ustalamy cele migracji i wybieramy platformę Data Lakehouse, która najlepiej odpowiada naszym potrzebom.

Kolejnym etapem jest przygotowanie danych. Tutaj skupiamy się na ich oczyszczeniu i transformacji. To jak pakowanie całego dobytku przed przeprowadzką , chcemy aby wszystko było uporządkowane i gotowe do łatwego dostępu.

Następnie przystępujemy do wdrożenia platformy Data Lakehouse. Instalujemy i konfigurujemy nowe narzędzia, a także integrujemy je z już istniejącymi systemami. To kluczowy moment, kiedy nasza 'nowa cyfrowa domowa baza danych’ zaczyna nabierać kształtów.

Migracja danych to serce całego procesu, przenosimy dane z Cloudery do nowego systemu Lakehouse. Migracja danych z Clouderowej infrastruktury do nowego systemu Lakehouse jest sercem procesu, który rozpoczynamy m.in. za pomocą narzędzi ETL’owych i dzięki temu możemy śledzić i monitorować przepływ danych. Metryki powstające w trakcie migracji pozwalają nam na wstępne zatwierdzenie poprawności jak i brak szybki przegląd ilości danych co zwiększa bezpieczeństwo całego procesu.Tu dbamy o to, aby wszystko przebiegło bezpiecznie i bez utraty danych.

Testowanie i walidacja to nasz etap kontroli jakości. Sprawdzamy, czy wszystkie systemy działają poprawnie, a dane są kompletnie i prawidłowo przeniesione.

Ostatnim krokiem jest monitorowanie i optymalizacja. Po migracji nieustannie obserwujemy, jak system się sprawuje, i optymalizujemy procesy, aby zapewnić maksymalną wydajność i efektywność.

Migracja do Lakehouse to nie tylko techniczna zmiana, to przede wszystkim strategiczne posunięcie, które może znacząco poprawić sposób, w jaki organizacja zarządza swoimi danymi.

Warto dodać, że na rynku pojawiły się nowoczesne rozwiązania lakehouse, które jeszcze bardziej ułatwiają i przyspieszają proces migracji. Dzięki tym nowym technologiom można połączyć oba środowiska, stare i nowe, pod jednym systemem.

Zamiast przenosić wszystko na raz, możemy stopniowo przekazywać dane do nowego systemu, jednocześnie zachowując ciągłość pracy obecnego systemu. To zmniejsza ryzyko przerw w dostępie do danych i pozwala na bieżące testowanie nowego środowiska bez destabilizacji działania firmy. Taka metoda nie tylko skraca czas potrzebny na migrację, ale także zwiększa bezpieczeństwo całego procesu.

Czy możesz podać przykład udanej migracji z Cloudery do Data Lakehouse?

Chętnie podzielę się historią jednego z naszych klientów z branży telekomunikacyjnej, który napotkał na poważne wyzwania w swojej infrastrukturze danych opartej na Clouderze. Codziennie mieli do przetwarzania aż 16 terabajtów danych, co przekładało się na wysokie koszty serwerów i licencji, jak również wymagało wysokiej wydajności i jakości w przetwarzaniu danych. Dodatkowo, brak wsparcia dla K8s i przestarzałe narzędzia zaczęły znacząco hamować rozwój ich systemu.

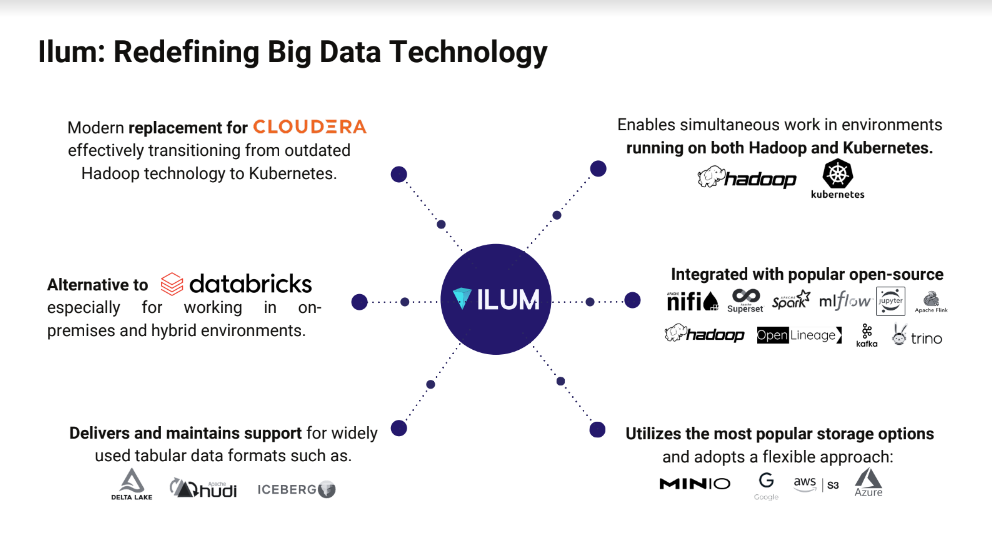

Po rozpoznaniu i dogłębnej analizie dostępnych opcji, zdecydowali się na migrację do platformy Ilum. Ilum przyciąga uwagę dzięki swojemu wszechstronnemu wsparciu dla Apache Spark oraz Kubernetes, co było kluczowe dla naszego klienta. Ponadto dostarcza automatycznie skonfigurowane środowisko out of the box wliczając nawet Data Lineage.

Wdrożenie systemu Ilum było strzałem w dziesiątkę. Dzięki lepszemu zarządzaniu danymi, nasz klient nie tylko uporał się z problemami technologicznymi, ale też zauważył wyraźne usprawnienia w przetwarzaniu i analizie danych.

Jakie korzyści wyniknęły z wdrożenia Ilum, jeśli chodzi o perspektywę klienta? Jak ocenia te działania?

Przejście na Ilum było dla naszego klienta telekomunikacyjnego prawdziwym przełomem.

Pierwsze i chyba najbardziej odczuwalne, to dwukrotnie szybsze przetwarzanie danych. To znacząco wpłynęło na efektywność ich działań operacyjnych. Wyobraźcie sobie, że wszystkie procesy, które wcześniej zajmowały godziny, teraz można zrealizować w połowę tego czasu. Dla klienta to nie tylko oszczędność czasu, ale realne zwiększenie możliwości realizacji kolejnych projektów. Co ciekawe, w niektórych ekstremalnych przypadkach, dzięki specjalnej funkcji Ilum, jaką są interaktywne sesje, udało nam się zauważyć przyspieszenie nawet o 90%. To naprawdę robi różnicę!

Drugi ważny aspekt to oszczędności, które sięgnęły 60%. Redukcja kosztów operacyjnych pozwoliła im przeznaczyć zaoszczędzone środki na rozwój innych kluczowych obszarów swojej działalności. To klasyczny przykład tego, jak inwestycja w nowe technologie może przynieść korzyści wielopoziomowe.

Trzeci punkt, który chciałbym podkreślić, to bezpieczeństwo. W dzisiejszych czasach, gdy dane są tak cenne, zachowanie wysokiego poziomu bezpieczeństwa i zgodności z regulacjami jest absolutnie kluczowe. Ilum pozwolił nam utrzymać te standardy nawet podczas skomplikowanego procesu migracji.

Co więcej, nasz klient zyskuje na elastyczności i możliwościach skalowania. Dzięki Ilum mogą teraz łatwiej dostosowywać systemy do swoich potrzeb.

Uproszczony proces migracji to kolejna kluczowa korzyść. Dzięki Platformie Ilum cała operacja przebiegła gładko, z minimalnym ryzykiem przestojów czy problemów technicznych.

Na koniec warto wspomnieć o lepszym zarządzaniu metadanymi. Ilum ułatwia organizację i efektywne zarządzanie metadanymi, to właśnie ten obszar ciągle wymaga uwagi w wielu organizacjach. Zawiera on duży zakres informacji, wykorzystanie których może znacząco poprawić dokładność analizy danych oraz wnioski biznesowe wyciągnięte na podstawie tej analizy.

Dzięki tym zmianom, operacje naszego klienta stały się bardziej płynne i efektywne. To wszystko przekłada się na lepsze zarządzanie zasobami i procesami, co jest ogromnym sukcesem zarówno dla nich, jak i dla nas, jako dostawcy rozwiązania.

To imponujące rezultaty! Opowiedz, proszę, nieco więcej o Ilum. Jakie ma zastosowanie? Jakie ma zalety?

Platforma Ilum to naprawdę potężne narzędzie, które zrewolucjonizowało sposób, w jaki pracujemy z ogromnymi ilościami danych. Jako platforma Data Lakehouse, Ilum jest zaprojektowany do elastycznego i efektywnego zarządzania Apache Spark na klastrach Kubernetes, co czyni go idealnym rozwiązaniem zarówno dla środowisk chmurowych, jak i on-premise.

Na co dzień korzystamy z wielu funkcji Ilum, które znacznie usprawniają naszą pracę. Na przykład, narzędzia takie jak Jupyter, Apache Airflow i MLflow są zintegrowane bezpośrednio z platformą, co pozwala nam na szybkie i efektywne analizy oraz automatyzację złożonych procesów obliczeniowych.

Ilum obsługuje języki Python i Scala, co daje nam elastyczność w przetwarzaniu danych i pozwala na adaptację do różnych wymagań projektowych. Dzięki interaktywnym sesjom, które wcześniej wspomniałem, możemy znacznie przyspieszyć czas odpowiedzi systemu, co jest kluczowe w sytuacjach wymagających szybkiego dostępu do danych.

Główne zalety Ilum to nie tylko wysoka wydajność i skalowalność, ale także oszczędności, które są niezwykle ważne dla każdej firmy. Redukcja kosztów infrastruktury o 60% pozwoliła naszemu klientowi znacznie lepiej zarządzać budżetem i reinwestować oszczędności w inne strategiczne obszary swojej działalności.

Co ważne, Ilum doskonale sprawdza się w różnych branżach, od finansów, przez handel detaliczny, opiekę zdrowotną, po telekomunikację i energetykę. Jego zdolność do zarządzania ogromnymi zbiorami danych i wspierania zaawansowanych analiz sprawia, że jest to idealne rozwiązanie dla sektorów, które potrzebują nie tylko gromadzić, ale i inteligentnie analizować informacje.

Dzięki Ilum nasze projekty stały się bardziej efektywne, a klienci cieszą się z lepszego przetwarzania i analizy danych. To dla mnie jako inżyniera oprogramowania niezwykle satysfakcjonujące, widzieć jak nowoczesne technologie mogą realnie wpływać na rozwój i efektywność biznesową.

Efekty najlepiej opisuje opinia klienta (Kamil Raróg, Head of Engineering, firma Elisa Polystar)

Ilum wygrywa tym, że jest rozwiązaniem darmowym i szeroko dostępnym, nie mamy ograniczeń co do rodzaju środowiska tzn. działa równie dobrze w cloudzie, na on-premach i jak środowiskach mieszanych. Ilum zastępuje nam Databricksa tam, gdzie mamy clouda i Cloudere CDP na onpremach i jeżeli chodzi o możliwości migracji z Yarna na Kubernetesa to nie ma konkurencji. Pozwolił nam zejść z kosztów licencji do zera. Dzięki ilumowym interaktywnym sesjom udało nam się zaoszczędzić średnio 20 sekund na pojedyncze zadanie analityczne gdzie uruchamiamy takich 900 tysięcy tygodniowo. Daje to nam 20000 zaoszczędzonych godzin miesięcznie, co bezpośrednio przekłada się na koszty wykorzystania infrastruktury.

Marcin Głowacki. Doświadczony inżynier oprogramowania z Wrocławia, specjalizujący się w technologiach Big Data oraz Cloud. Od kwietnia 2020 roku pracuje w Sofixit, gdzie przez ponad cztery lata rozwijał swoje umiejętności w zakresie przetwarzania danych i integracji z różnymi systemami danych. Jest pasjonatem nowych technologii i zawsze dąży do doskonalenia swoich umiejętności oraz poszukiwania innowacyjnych rozwiązań.

Podobne artykuły

Technologia wespół w zespół z biznesem w dmTECH [WYWIAD]

“Tu się rośnie” o pracy z danymi, która ma sens – rozmowa z Przemysławem Fabianowicz z Infinite Services.

Co wspólnego ma IT z branżą FMCG? Wywiad z Michałem Biedzińskim

Maciej Kawecki: "Przełomy technologiczne będą działy się z tygodnia na tydzień" [WYWIAD]

PashaBiceps o życiu zawodowego gracza e-sportowego: "Spędzasz z drużyną 24 godziny na dobę"

Z automatyki do IT: Jak odnaleźć swoje miejsce w świecie technologii?

"Dobrze działający zespół daje wyniki" – o tym, jak ważne jest budowanie zespołu rozmawiamy z ekspertami firmy Ericsson